Có thể nói Công nghệ Chip đang được NVIDIA phát triển mạnh mẽ và đây là những gì mà NVIDIA giới thiệu cho các công ty chuyên về AI dược biết và hiểu về nó, chúng tôi xin Viết 1 bài về hội thảo đó đang được diễn ra.

Một số hội thảo kỹ thuật đã được đề xuất

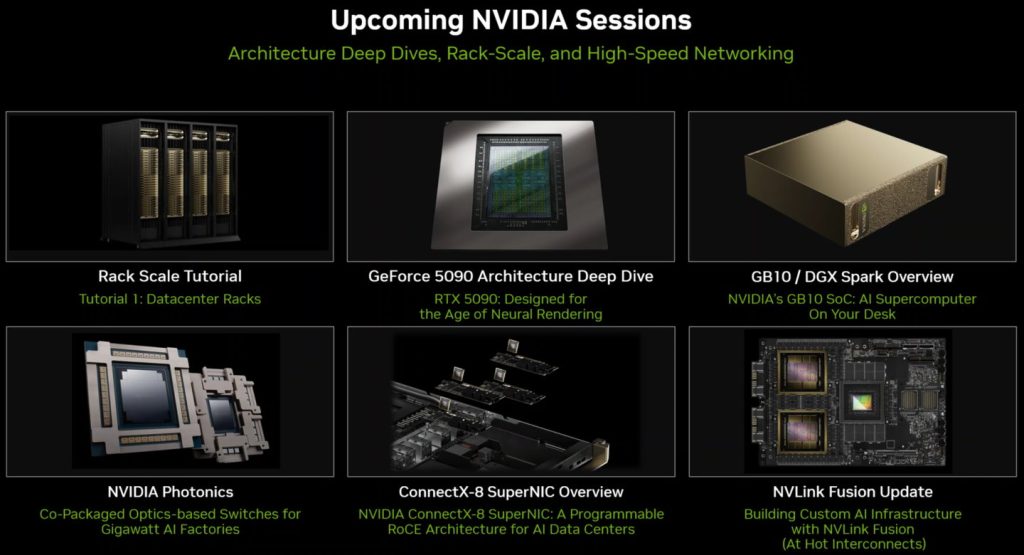

NVIDIA sẽ trình bày một số chương trình nghị sự quan trọng tại hội nghị Hot Chips 2025 được tổ chức tại Đại học Stanford từ ngày 24 đến 26 tháng 8 năm 2025, bao gồm các đơn vị tính toán cấp rack và cấp trung tâm dữ liệu thông qua chip mạng ConnectX-8 SuperNIC, Neural Rendering được hỗ trợ bởi card đồ họa GeForce RTX 50 series dựa trên Blackwell, Co-Packaged Optics Switches (CPO), GB10 Superchip và siêu máy tính mini DGX Spark, ứng dụng NVLink Fusion và nhiều dự án quan trọng khác.

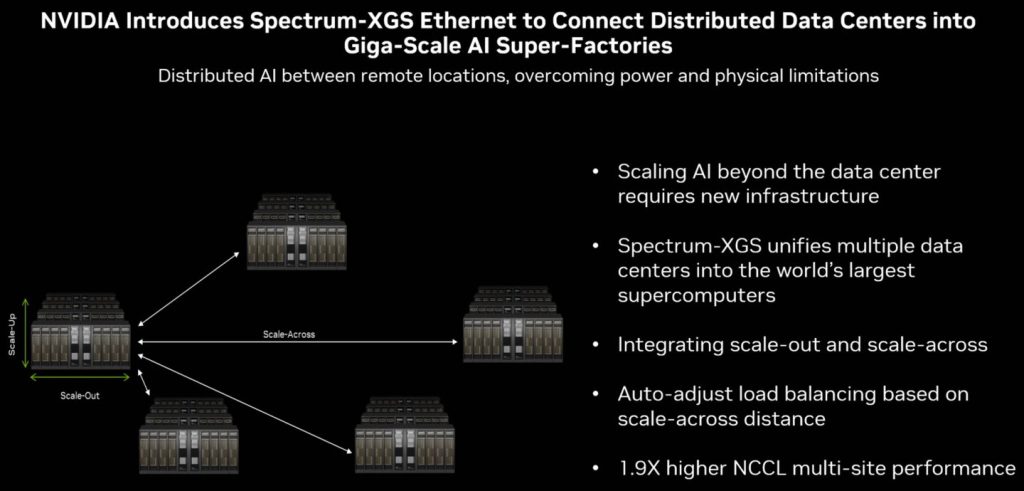

Một trong những tin tức quan trọng trong Hot Chips 2025 này là công nghệ kết nối Ethernet Spectrum-XGS kết nối nối tiếp nhiều trung tâm dữ liệu dựa trên Ethernet. Khác với các công nghệ trước đây như NVLink và ConnectX được áp dụng trong một rack hoặc trung tâm dữ liệu duy nhất, Ethernet Spectrum-X có thể được kết nối nối tiếp trên các trung tâm dữ liệu để đạt được hiệu quả của điện toán phân tán từ xa.

Khái niệm của NVIDIA về công nghệ này được gọi là Scale-Around, phá vỡ giới hạn khoảng cách của các trung tâm dữ liệu và kết hợp các nút tính toán ở các vị trí địa lý khác nhau thành một nút điện toán rất lớn duy nhất, không chỉ có thể cải thiện hiệu suất tính toán tổng thể mà còn mở rộng dung lượng bộ nhớ có sẵn để chứa các bộ dữ liệu lớn hơn hoặc mô hình AI với nhiều thông số hơn.

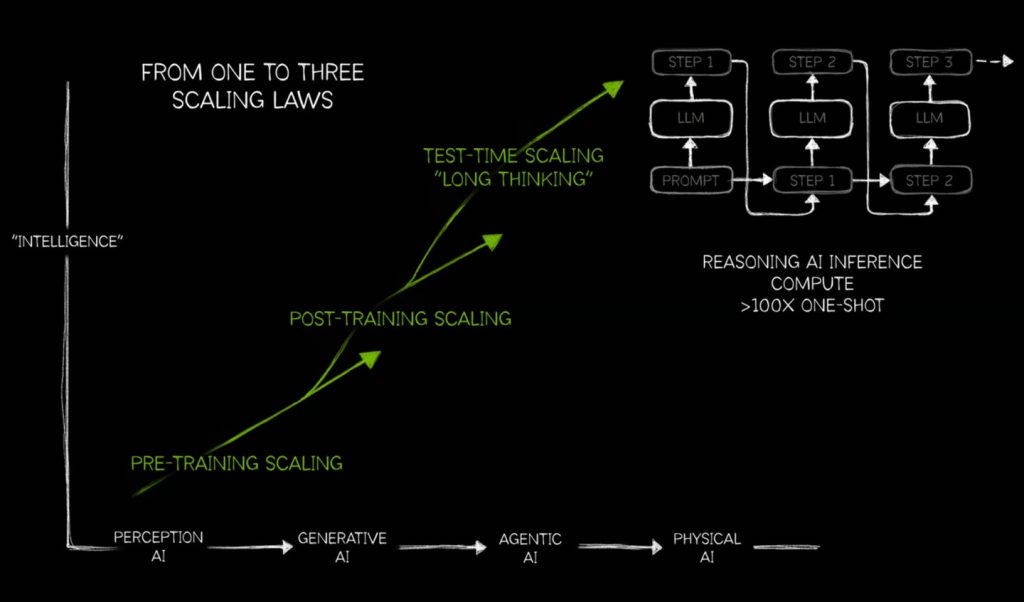

NVIDIA đã đề cập trong cuộc họp báo rằng với sự gia tăng của suy luận và AI tác nhân, nhu cầu về hiệu suất tính toán AI trong các ứng dụng đã tăng lên.

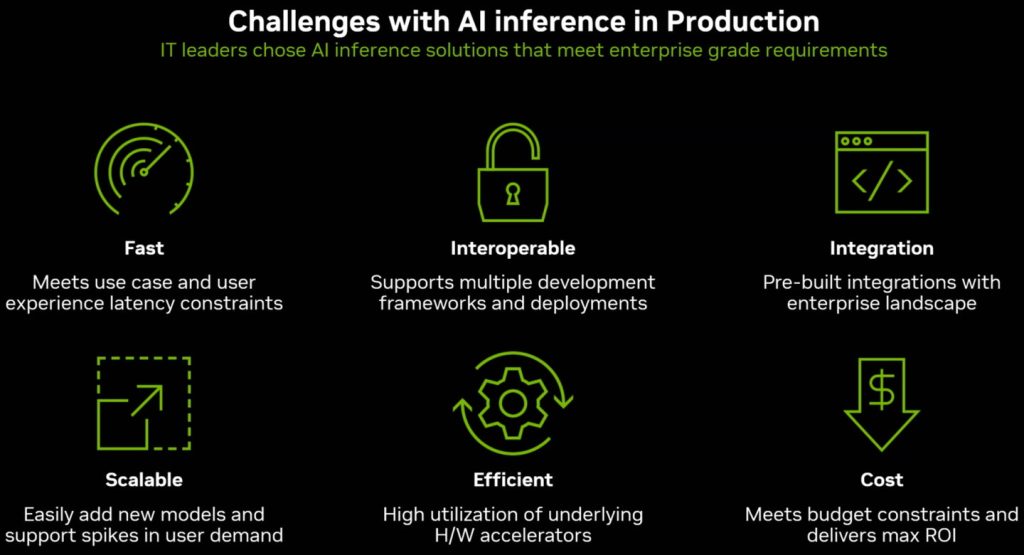

NVIDIA liệt kê tốc độ, khả năng tương tác, tích hợp, khả năng mở rộng, hiệu quả và chi phí là sáu thách thức chính của suy luận AI.

NVIDIA sẽ tổ chức một chương trình thảo luận về các chủ đề khác nhau như kết nối dữ liệu và kết xuất thần kinh tại hội nghị Hot Chips 2025.

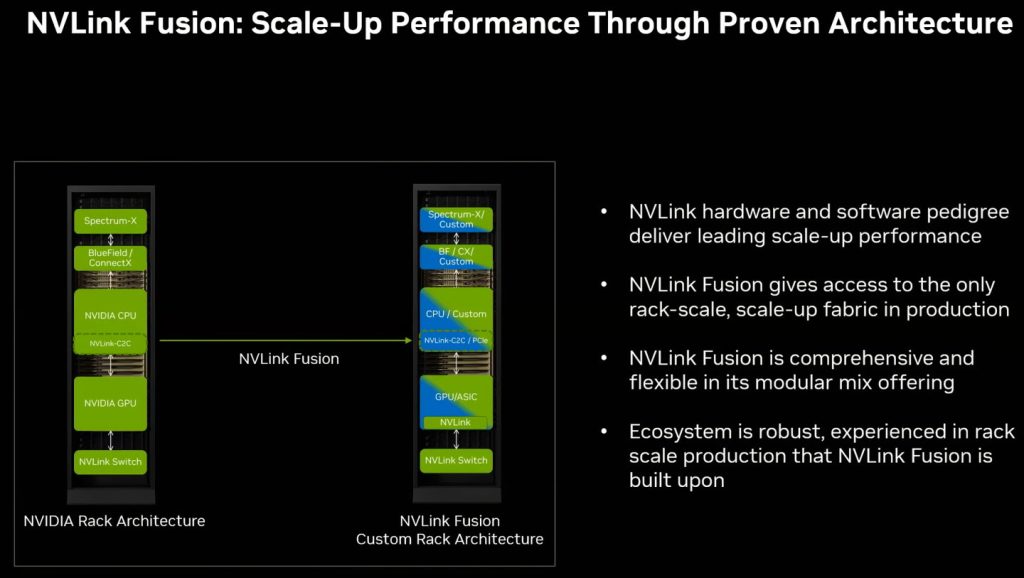

NVLink Fusion cung cấp sự linh hoạt trong cơ sở hạ tầng AI bán tùy chỉnh, cho phép các đối tác xây dựng máy chủ và tủ bằng cách sử dụng bộ xử lý tùy chỉnh, giao diện mạng, ASIC (mạch tích hợp dành riêng cho ứng dụng) và GPU NVIDIA.

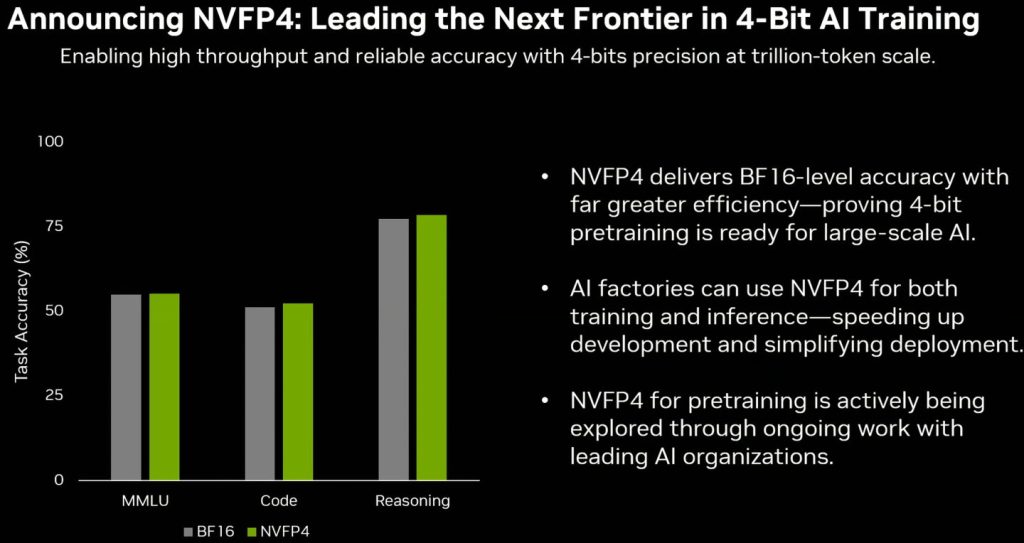

NVFP4 là loại dữ liệu sử dụng độ chính xác 4 bit, có thể tiết kiệm tài nguyên tính toán, chiếm dung lượng bộ nhớ và băng thông truyền trong quá trình đào tạo và suy luận AI, đồng thời cung cấp độ chính xác gần với BF16.

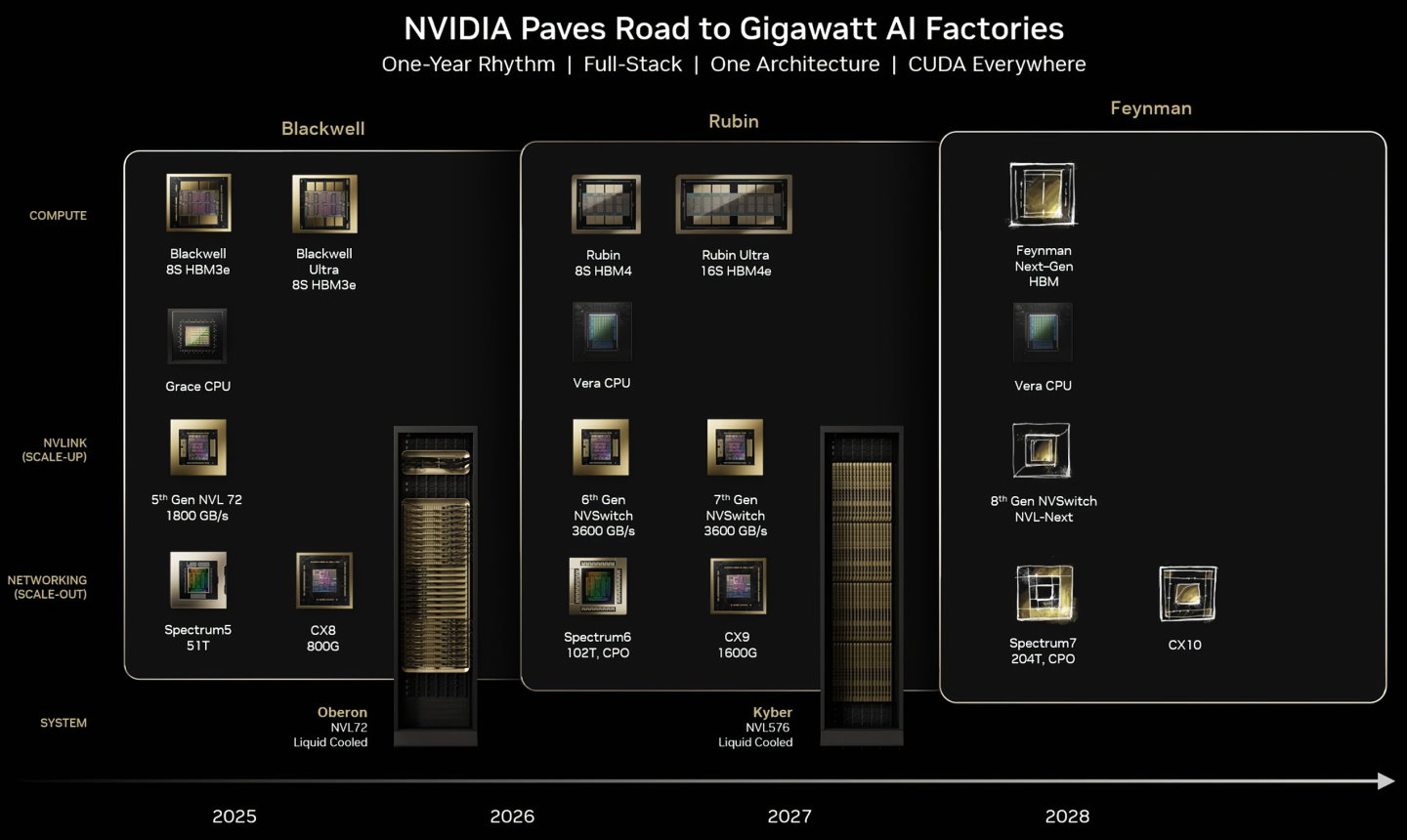

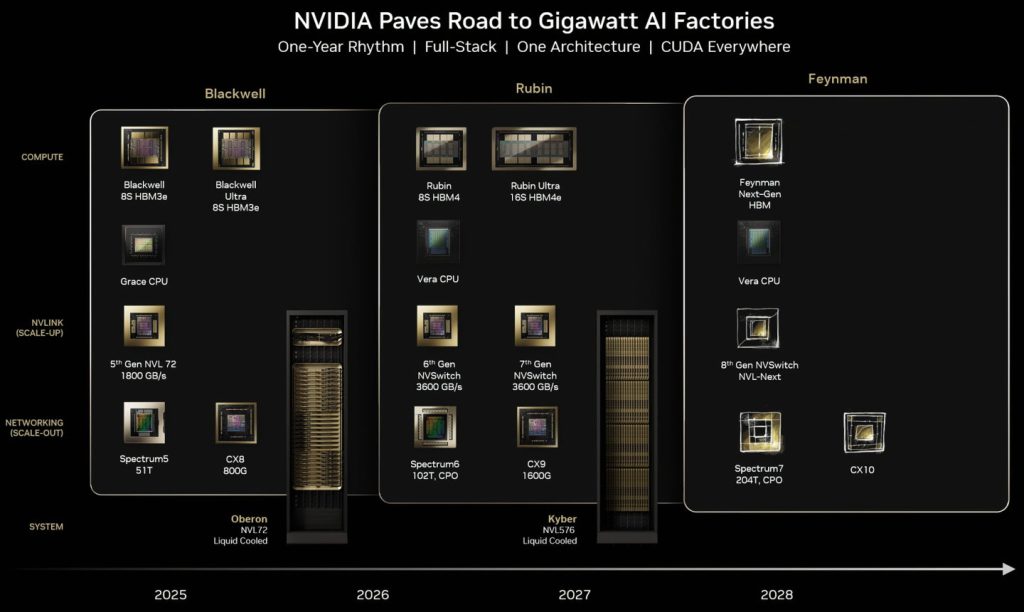

NVIDIA áp dụng sản phẩm cập nhật nhịp điệu giống như Tick-Tock, ra mắt Blackwell vào năm 2025, phiên bản nâng cao của Blackwell Ultra vào năm 2026 và chuyển sang kiến trúc Rubin vào năm 2027

Tích hợp nhiều trung tâm dữ liệu từ xa thông qua mạng

So với Scale-Up, cải thiện hiệu suất của một nút tính toán đơn lẻ hoặc Scale-Out, tính toán nhiều nút nối tiếp để cải thiện hiệu suất tổng thể (nhưng mỗi nút tính toán vẫn nằm trong cùng một trung tâm dữ liệu), khái niệm Scale-Around tập trung vào việc kết nối các nút điện toán từ xa trong các trung tâm dữ liệu khác nhau theo chuỗi, cung cấp các kênh trao đổi dữ liệu băng thông cao, độ trễ cực thấp và điều phối GPU-to-GPU (GPU, Nó có thể tăng tốc tính toán các bộ dữ liệu khổng lồ giữa điện toán AI và tích hợp nhiều trung tâm dữ liệu độc lập vào một nhà máy siêu AI duy nhất để đáp ứng nhu cầu của điện toán AI quy mô giga.

Nói một cách đơn giản, Scale-Around là khái niệm kêu gọi anh em từ xa đến giúp đỡ, và mọi người cùng nhau chiến đấu, bằng cách tích hợp sức mạnh tính toán của nhiều trung tâm dữ liệu để mang lại hiệu suất tổng thể cao hơn.

Về mặt lý thuyết, khái niệm Scale-Around chắc chắn sẽ có nhược điểm là độ trễ cao hơn và băng thông thấp hơn so với Scale-Out do khoảng cách truyền dữ liệu dài, nhưng ưu điểm của nó là nó có thể phá vỡ rào cản khoảng cách và vì nhiều trung tâm dữ liệu nằm ở các khu vực khác nhau, nó có thể giảm bớt áp lực của một nguồn điện lưới duy nhất và có thể linh hoạt điều phối các trung tâm dữ liệu khác nhau để tính toán tích hợp, có thể phụ thuộc vào tình hình tải của từng trung tâm dữ liệu, Múi giờ (tải ban đêm nhẹ hơn và chi phí điện rẻ hơn) tối ưu hóa lập lịch trình tài nguyên để sử dụng linh hoạt hơn.

NVIDIA giải thích rằng Spectrum-XGS Ethernet dựa trên nền tảng Spectrum-X Ethernet, người sáng lập và Giám đốc điều hành NVIDIA Jensen Huang cho biết cuộc cách mạng công nghiệp AI đang diễn ra và các nhà máy AI lớn hơn là cơ sở hạ tầng cần thiết, với sự trợ giúp của Spectrum-XGS Ethernet, Chúng tôi đã giới thiệu khái niệm Scale-Around sáng tạo bên cạnh Scale-Up và Scale-Out hiện có, tập hợp các trung tâm dữ liệu ở các thành phố, quốc gia và đại lục khác nhau thành một số lượng siêu lớn các nhà máy siêu AI.

Hội nghị này sẽ kết thúc vào ngày 28/8 năm 2025, nếu các bạn quan tâm đến lĩnh vực này có thể theo dõi các bài viết của chúng tôi, tôi đang quan tâm đến Google phát biểu về lĩnh vực phần cứng chip nhằm phát hiện các đánh giá google maps, để tối ưu hoá cũng như phát huy điểm mạnh công nghệ cốt lõi google đang nắm giữ.